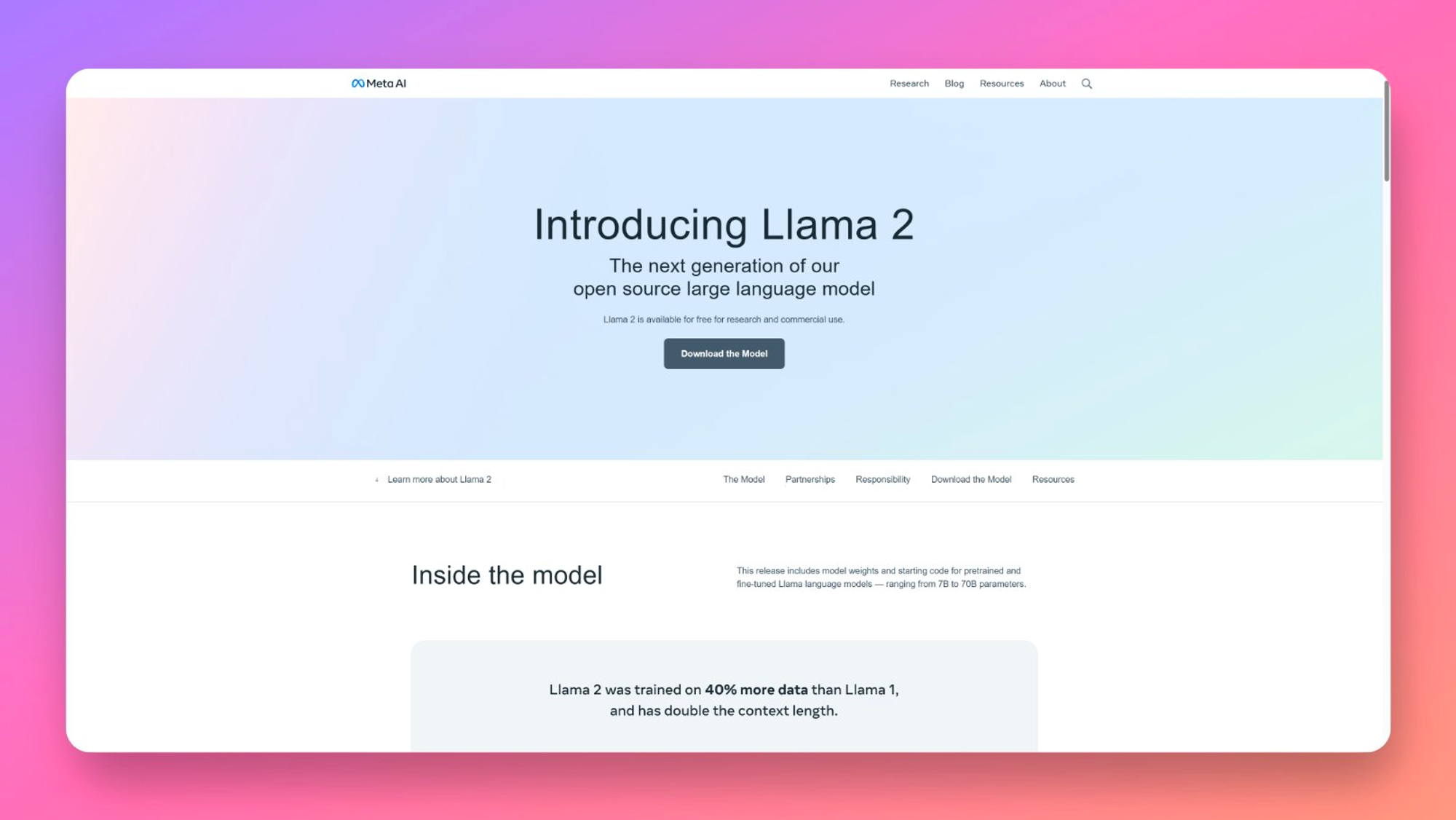

Meta 发布并开源了 Llama 2 大语言模型

上周三 Meta 正式发布了和开源了Llama 2 大语言模型,估计接下来的两个月开源语言模型和国产的一些模型都回迎来性能上的飞跃。

模型规模方面Llama2有三个大小的版本分别是7B 13B和70B,Llama 2 的训练数据比 Llama 1 多 40%,上下文长度是 Llama 1 的两倍。预训练的Token为2 万亿,上下文长度为4096。

与第一次泄漏的版本不同,这次Meta开放了商业使用的权限。虽然开源但是 Llama 2 也有一些限制条件,比较重要的就是不允许将Llama 材料或 Llama 材料的任何输出或结果来改进任何其他大型语言模型,还有就是日活大于 7 亿的产品商业使用需要单独申请。

Llama 2官网:https://ai.meta.com/llama/

Llama 2训练的论文介绍:https://ai.meta.com/research/publications/llama-2-open-foundation-and-fine-tuned-chat-models/

Huggingface的模型下载地址:https://huggingface.co/meta-llama

官方模型申请地址:https://ai.meta.com/resources/models-and-libraries/llama-downloads/

在线试用 7B、13B:https://llama.perplexity.ai/

70B 模型试用:https://huggingface.co/chat/

未经允许不得转载:表盘吧 » Meta 发布并开源了 Llama 2 大语言模型